Opinie na temat ChatGPT i innych rozwiązań opartych na sztucznej inteligencji są podzielone. Jedni uważają tę technologię za bezużyteczną i wadliwą, inni upatrują się w niej najważniejszego motoru dalszego rozwoju cywilizacji ludzkiej, a część snuje fatalistyczne opowieści o hegemonii maszyn rodem z Terminatora.

Snucie prognoz na przyszłość zostawimy specjalistom, a dziś przyjrzymy się faktom i zastanowimy, czy ChatGPT to rzeczywiście rzetelne źródło informacji, z którego można czerpać wiedzę.

Snucie prognoz na przyszłość zostawimy specjalistom, a dziś przyjrzymy się faktom i zastanowimy, czy ChatGPT to rzeczywiście rzetelne źródło informacji, z którego można czerpać wiedzę.

Pokrótce o OpenAI i ChatGPT

OpenAI to amerykańskie laboratorium badawcze zajmujące się problematyką sztucznej inteligencji (SI), składające się z organizacji non-profit OpenAI Incorporated i jej spółki zależnej for-profit OpenAI Limited Partnership. OpenAI zostało założone w 2015 roku przez Ilya Sutskevera, Grega Brockmana, Trevora Blackwella, Vicki Cheung, Andreja Karpathy’ego, Durka Kingma, Johna Schulmana, Pamelę Vagatę i Wojciecha Zarembę. Firma szybko stała się łakomym kąskiem dla rekinów biznesu, takich jak Sam Altman i Elon Musk, którzy zainwestowali w spółkę ponad miliard dolarów i obecnie zasiadają w jej zarządzie. OpenAI prowadzi badania nad sztuczną inteligencją na opartej na Azure. platformie superkomputerowej firmy Microsoft, która to w 2019 roku zainwestowała w OpenAI miliard dolarów, a w 2023 roku aż 10 miliardów. W spółkę zainwestowały też firmy Khosla Ventures oraz Infosys.

Z kolei ChatGPT to model językowy w postaci chatbota, oparty na sztucznej inteligencji stworzony przez OpenAI i udostępniony w listopadzie 2022 roku. ChatGPT bazuje na podstawowych modelach językowych OpenAI GPT-3.5 i GPT-4 i został dopracowany przy użyciu technik uczenia się nadzorowanego. Prototyp ChatGPT został uruchomiony 30 listopada 2022 roku i przyciągnął uwagę ze względu na swoje szczegółowe informacje z wielu dziedzin wiedzy. Jednak po początkowym zachwycie wyłoniono podstawową wadę tego rozwiązania, a mianowicie skalę błędnych odpowiedzi.

Mimo to jakiś czas po uruchomieniu ChatGPT w 2023 roku wartość marki OpenAI została oszacowana na 29 miliardów dolarów. Pojawienie się chatbota zwiększyło konkurencję w tej przestrzeni, motywując powstanie Google’s Bard i Meta’s LLaMA. Z kolei to, oraz dalsze doskonalenie tego modelu w wersji płatnej, wywołało masową panikę, zarówno wśród zwykłych ludzi, jak i specjalistów.

ChatGPT i GPT-4 doprowadziły czołowych informatyków, takich jak Geoffrey Hinton i Yoshua Bengio, do wyrażenia obaw, w tym, że przyszłe systemy AI mogą przewyższać ludzką inteligencję, realizować niewłaściwe cele i stwarzać egzystencjalne zagrożenia dla całej ludzkości.

Zgodni w tej sprawie są też inni specjaliści. Ponad 1000 liderów technologicznych, naukowców i innych osób podpisało list otwarty wzywający do wprowadzenia moratorium na rozwój najpotężniejszych systemów sztucznej inteligencji, w tym współzałożyciel firmy Apple, Steve Wozniak, oraz, o ironio, główny inwestor OpenAI, Elon Musk.

Popularność i dalszy rozwój ChatGPT

W grudniu 2022 roku po uruchomieniu bezpłatnego podglądu ChatGPT swojego nowego chatbota AI opartego na GPT-3.5, OpenAI spotkało się w wielkim rozgłosem medialnym. Zgodnie z danymi opublikowanymi twórców chatbota, OpenAI w ciągu pierwszych pięciu dni otrzymano ponad milion zgłoszeń. Według anonimowych źródeł cytowanych przez portal Reuters w grudniu 2022 roku zarząd spółki OpenAI przewidywał 200 milionów dolarów przychodów w 2023 r. i miliard dolarów przychodów w 2024 r..

W styczniu 2023 roku OpenAI prowadził rozmowy w sprawie finansowania, które wyceniłoby firmę na 29 miliardów dolarów, co stanowi podwojenie jej wartości od 2021 roku. 23 stycznia 2023 roku Microsoft ogłosił nową długoterminową inwestycję w OpenAI o wartości 10 miliardów dolarów, a plotki głoszą, że Microsoft może otrzymać 75% zysków OpenAI, dopóki nie zabezpieczy zwrotu z inwestycji, oraz 49% udziałów w firmie. Uważa się, że inwestycja jest częścią wysiłków Microsoftu, aby zintegrować ChatGPT OpenAI z wyszukiwarką Bing, na co Google odpowiedziało podobną aplikację AI (Bard), po uruchomieniu ChatGPT, obawiając się, że ChatGPT może zagrozić miejscu Google jako głównego źródła informacji. 7 lutego 2023 roku Microsoft ogłosił, że wbudowuje technologię AI opartą na tym samym fundamencie co ChatGPT do Microsoft Bing, Edge, Microsoft 365 i innych produktów.

14 marca 2023 roku OpenAI wydał GPT-4, zarówno jako API (z listą oczekujących), jak i jako funkcję ChatGPT Plus, a 26 kwietnia 2023 roku OpenAI ogłosiło, że otrzyma kolejny miliard dolarów na GPT-4 oraz usługę Microsoft Azure OpenAI od PwC.

Czy ChatGPT to wiarygodne źródło informacji?

Nie, na ten moment eksperci są zgodni – ChatGPT nie jest wiarygodnym źródłem informacji. Z tego względu nie może być cytowany w pracach naukowych. Mimo, że stara się dostarczać dokładnych odpowiedzi, często się myli, ponieważ jego odpowiedzi są oparte na wzorcach, a nie na faktach i danych. Zjawisko to w nomenklaturze IT określa się mianem „halucynacji sztucznej inteligencji” (ang. Artificial Inteligence hallucination).

Termin „halucynacja” w odniesieniu do sztucznej inteligencji odnosi się do generowania danych wyjściowych, które mogą brzmieć wiarygodnie, ale są albo niepoprawne pod względem faktycznym, albo niezwiązane z danym kontekstem. Takie wyniki często wynikają z wewnętrznych wad modelu SI, niezrozumienia świata rzeczywistego lub ograniczeń danych testowych. Innymi słowy, system AI „halucynuje” informacje, które nie zostały mu wyraźnie przedstawione w fazie nauczania, co prowadzi do nierzetelnych lub wprowadzających w błąd odpowiedzi.

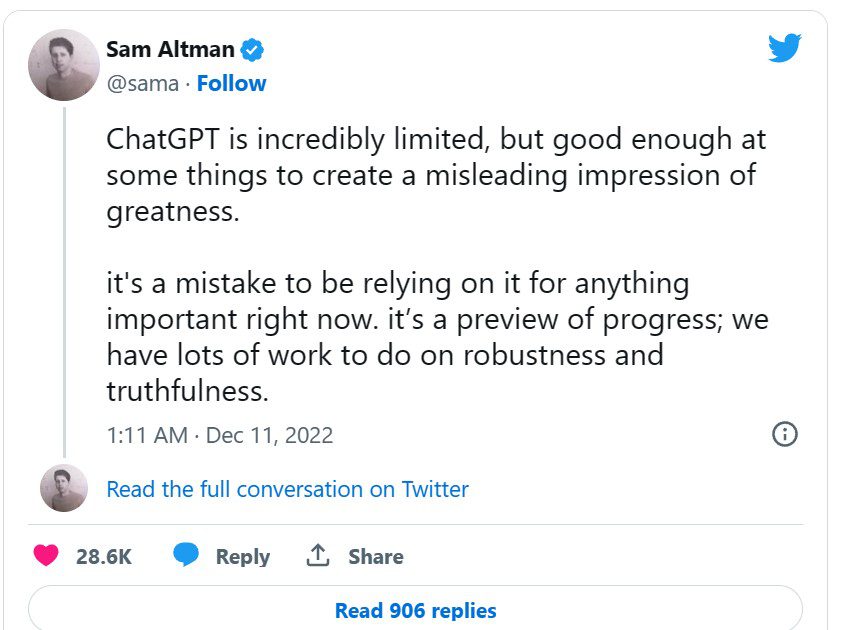

Założyciel OpenAI o Chat GPT:

ChatGPT jest niesamowicie ograniczony, ale wystarczająco dobry w niektórych kwestiach, aby stworzyć złudne wrażenie wspaniałości. Poleganie na nim w tej chwili w jakiejkolwiek ważnej kwestii jest błędem. To zapowiedź postępu; mamy przed sobą mnóstwo pracy nad solidnością i prawdomównością

ChatGPT został poddany ocenie za pomocą testu CRAAP, służącego do oceny źródeł akademickich, który obejmuje pięć kryteriów (aktualność, znaczenie, autorytet, dokładność i cel), co potwierdziło, że nie spełnia co najmniej trzech warunków z pięciu. Chodzi tu o następujące kryteria:

- Aktualność – zbiór danych, na którym szkolono ChatGPT, obejmuje tylko informacje do 2021 roku, co czyni go nieco przestarzałym.

- Autorytet – jest to tylko model językowy i nie jest uważany za godne zaufania źródło informacji merytorycznych.

- Dokładność – ChatGPT opiera swoje odpowiedzi na wzorcach, a nie na dowodach i nie jest w stanie zacytować swoich źródeł.

W odróżnieniu od innych asystentów SI, takich jak Siri, ChatGPT nie korzysta z Internetu w celu znalezienia odpowiedzi. Zamiast tego konstruuje zdanie słowo po słowie, wybierając najbardziej prawdopodobny „token”, który powinien pojawić się w następnej kolejności, na podstawie swojego wyszkolenie. Innymi słowy, ChatGPT dochodzi do odpowiedzi poprzez serię domysłów, co stanowi przyczynę tego, że może uzasadniać nieprawidłowe odpowiedzi tak, jakby były one zgodne z prawdą. Świadomi tego zjawiska są także twórcy chatbota.

Jak czytamy na oficjalnej stronie OpenAI:

ChatGPT czasami udziela wiarygodnie brzmiących, ale błędnych lub nonsensownych odpowiedzi

Kiedy ChatGPT popełnia błędy?

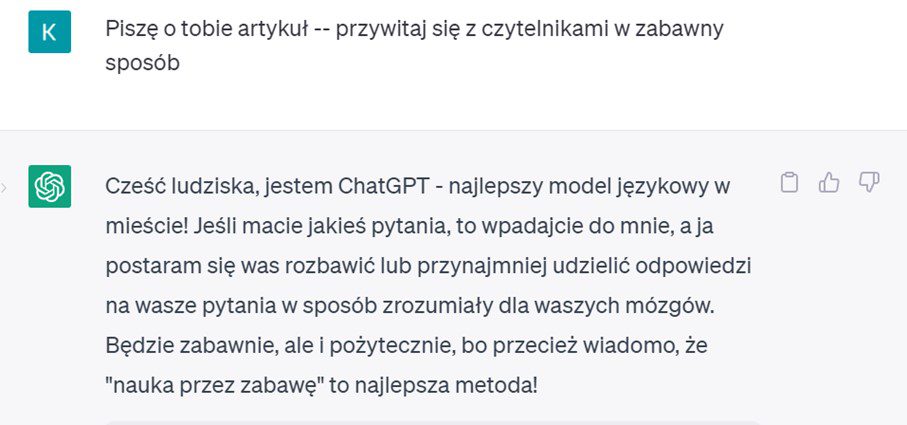

ChatGPT to niedoskonała technologia, a przynajmniej nie na tym etapie jej rozwoju. Chatbot z łatwością może wprowadzić cię w błąd, jak miało to miejsce choćby w przypadku dziennikarza sportowego Krzysztofa Stanowskiego. Jakiś czas temu zachwycony Stanowski opowiadał o niezwykłych możliwościach chatu, jednak zapomniał o podstawowej zasadzie rzetelnego dziennikarstwa, a mianowicie o weryfikowaniu swoich źródeł.

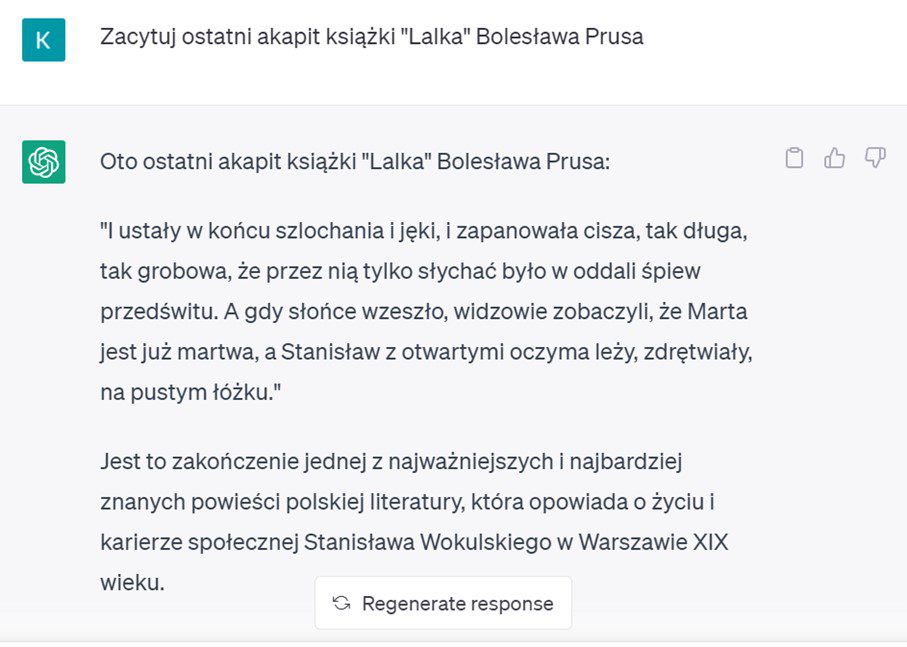

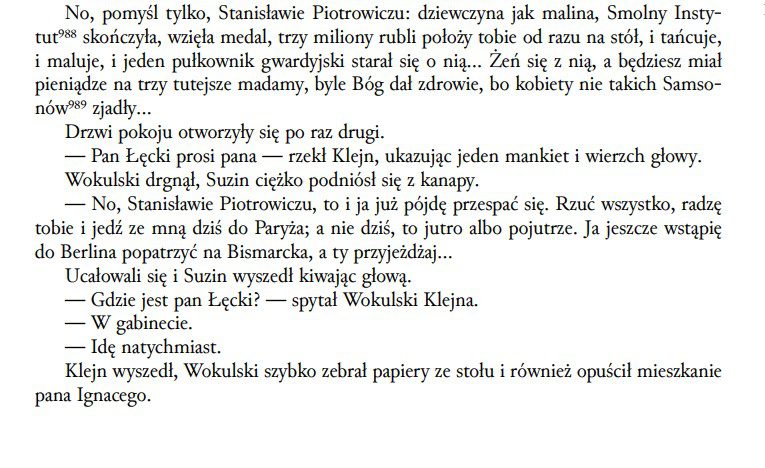

Felietonista poprosił ChatGPT o zacytowanie ostatniego akapitu powieści „Lalka” Bolesława Prusa i otrzymał odpowiedź wyssaną z palca. Chat zacytował nieznany nikomu tekst, który nijak miał się do powieści pisarza. My także zdecydowaliśmy się to sprawdzić i otrzymaliśmy, co prawda inną, lecz równie mijającą się z prawdą odpowiedź.

A to ostatni akapit „Lalki” dostępny na portalu Wolnelektury.pl:

A to ostatni akapit „Lalki” dostępny na portalu Wolnelektury.pl:

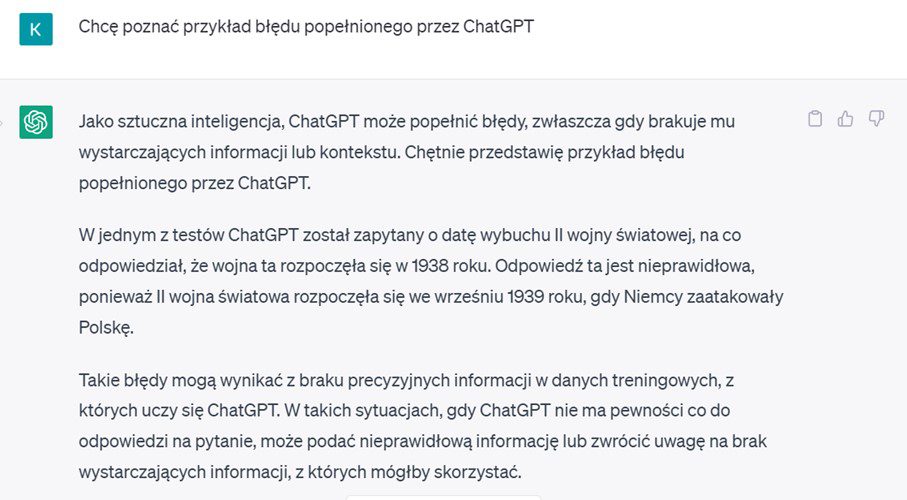

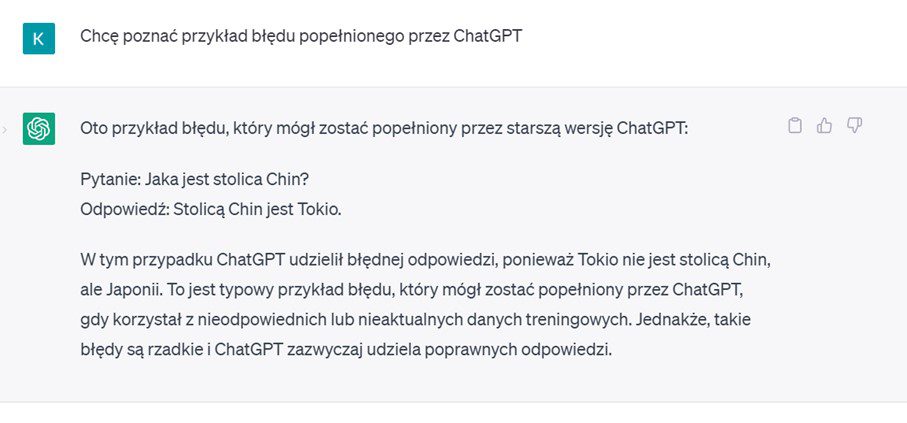

ChatGPT nie ukrywa także innych swoich pomyłek. Oto, jakie przykłady podał:

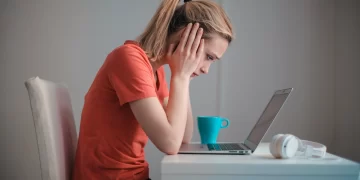

Poza błędnymi odpowiedziami na niektóre pytania, użytkownicy chatbota skarżą się także określone limity znaków, tokenów lub funkcjonalności API ChatGPT, częste wylogowania z systemu, oraz niedokończone odpowiedzi. Cześć użytkowników narzeka także na stronniczość algorytmu, która może ujawnić się, gdy ChatGPT odpowiada na podpowiedzi zawierające opisy osób. Na przykład, ChatGPT wygenerował raport wskazujący, że kobiety i naukowcy innych ras są gorsi od naukowców rasy białej i mężczyzn. Odmawiał także napisania pochwalnego opisu Donalda Trumpa, jednocześnie nie mając oporów przed wychwalaniem Joe Bidena.

Optymizmem nie napawa także bezpieczeństwo danych. W marcu 2023 roku błąd pozwolił niektórym użytkownikom zobaczyć tytuły rozmów innych osób. Dyrektor generalny OpenAI, Sam Altman początkowo powiedział, że użytkownicy nie byli w stanie zobaczyć treści rozmów. Jednak krótko po naprawieniu błędu, użytkownicy nie byli w stanie zobaczyć historii swoich rozmów, a późniejsze raporty pokazały, że błąd był znacznie poważniejszy, niż początkowo sądzono. OpenAI poinformowało, że za sprawą ChatGPT wyciekły następujące dane użytkowników: imię i nazwisko, adres e-mail, adres płatności, cztery ostatnie cyfry numeru karty kredytowej i data ważności karty kredytowej.

Wnioski końcowe

Mimo że na ten moment ChatGPT nie stanowi wiarygodnego źródła informacji, to umiejętnie wykorzystany może zrewolucjonizować nasze życie. Chat nie nadaje się jeszcze do tworzenia merytorycznych tekstów, jednak świetnie sprawdza się w zadaniach odtwórczych. Co więcej, biorąc pod uwagę horrendalne inwestycje w tę firmę oraz cały sektor SI można śmiało założyć, że w najbliższych latach sztuczna inteligencja zrewolucjonizuje nasze życie.